Weiterhin baut auf dem Suchindex ein Web-Analysewerkzeug auf. Dieses zeigt defekte Links (und soll künftig noch weitere Hinweise liefern).

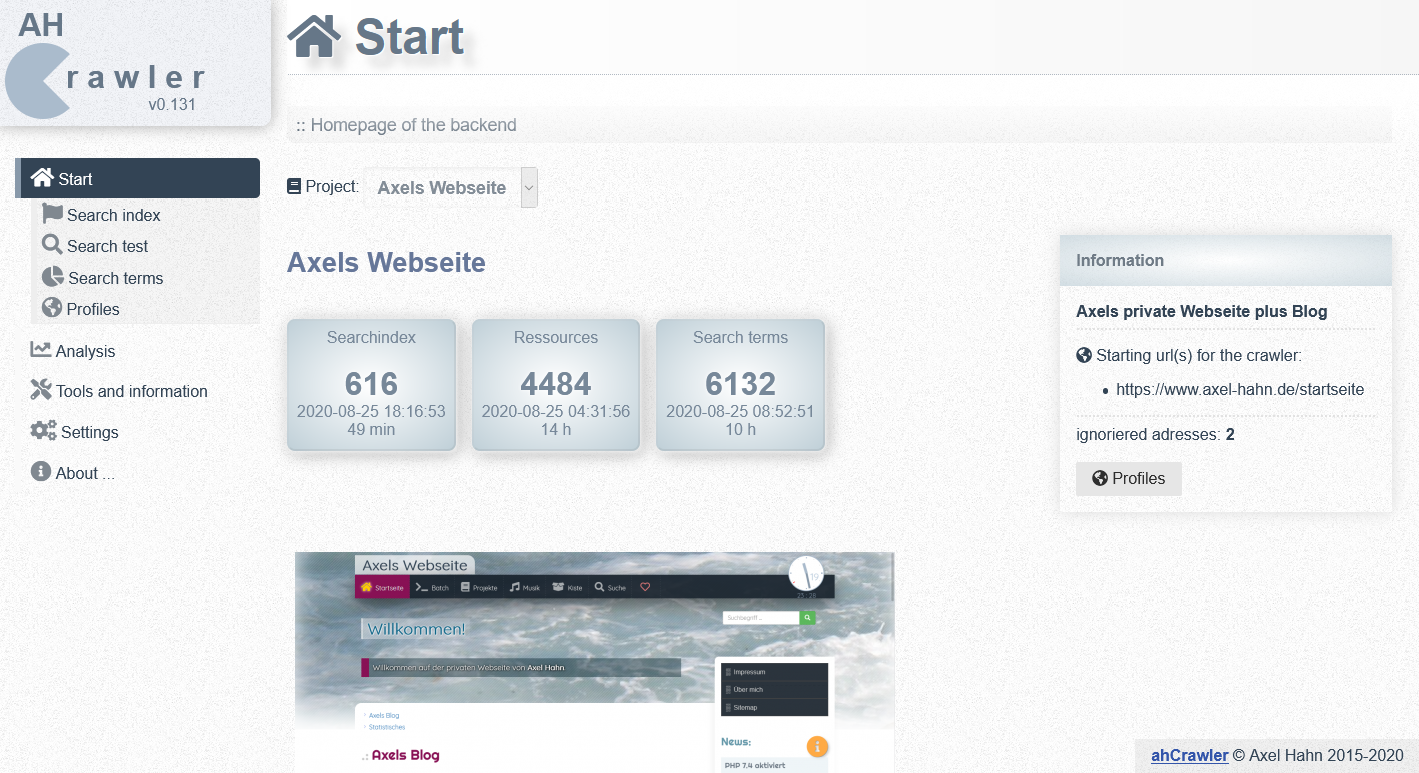

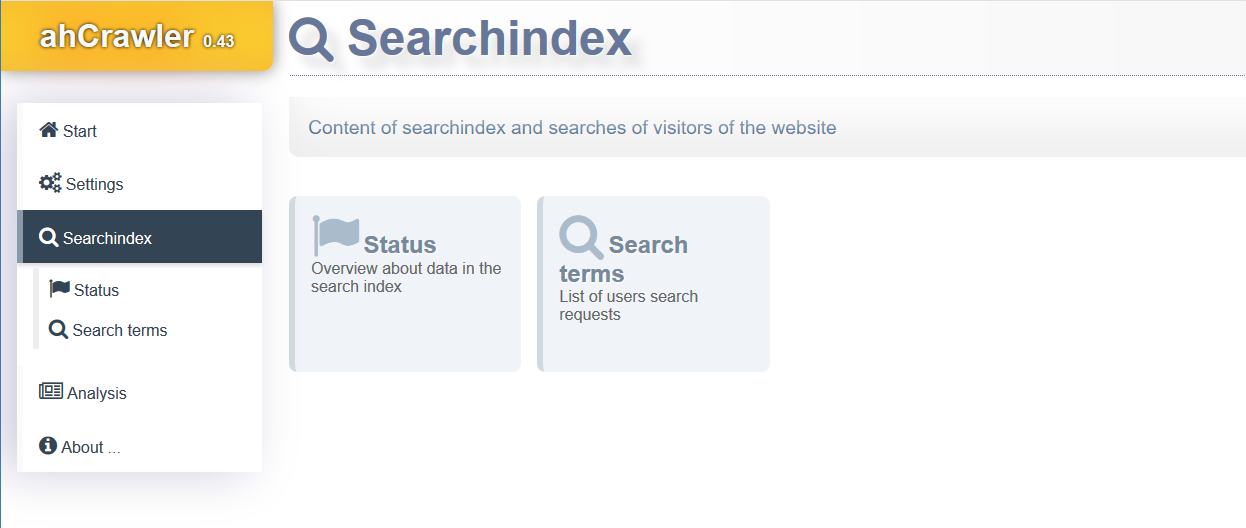

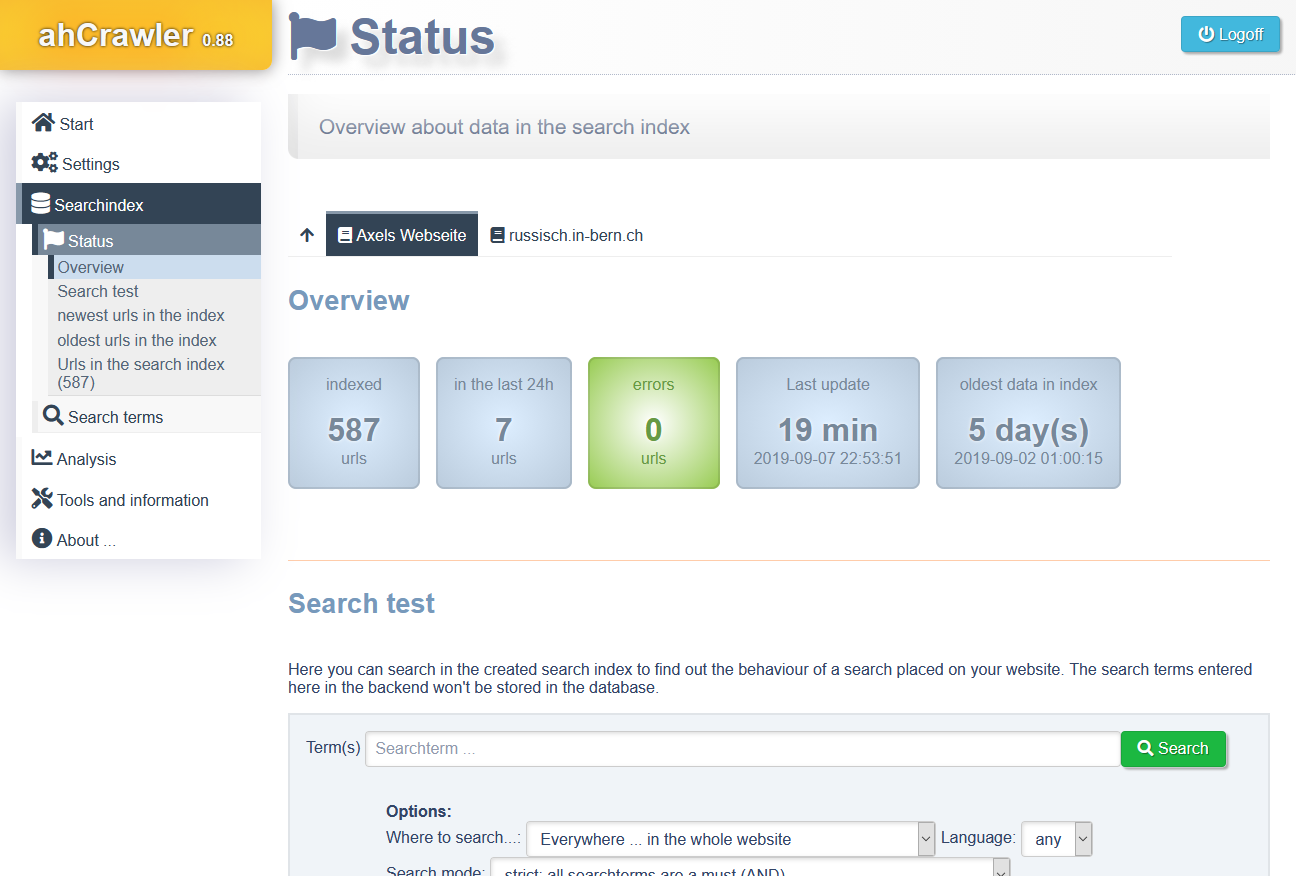

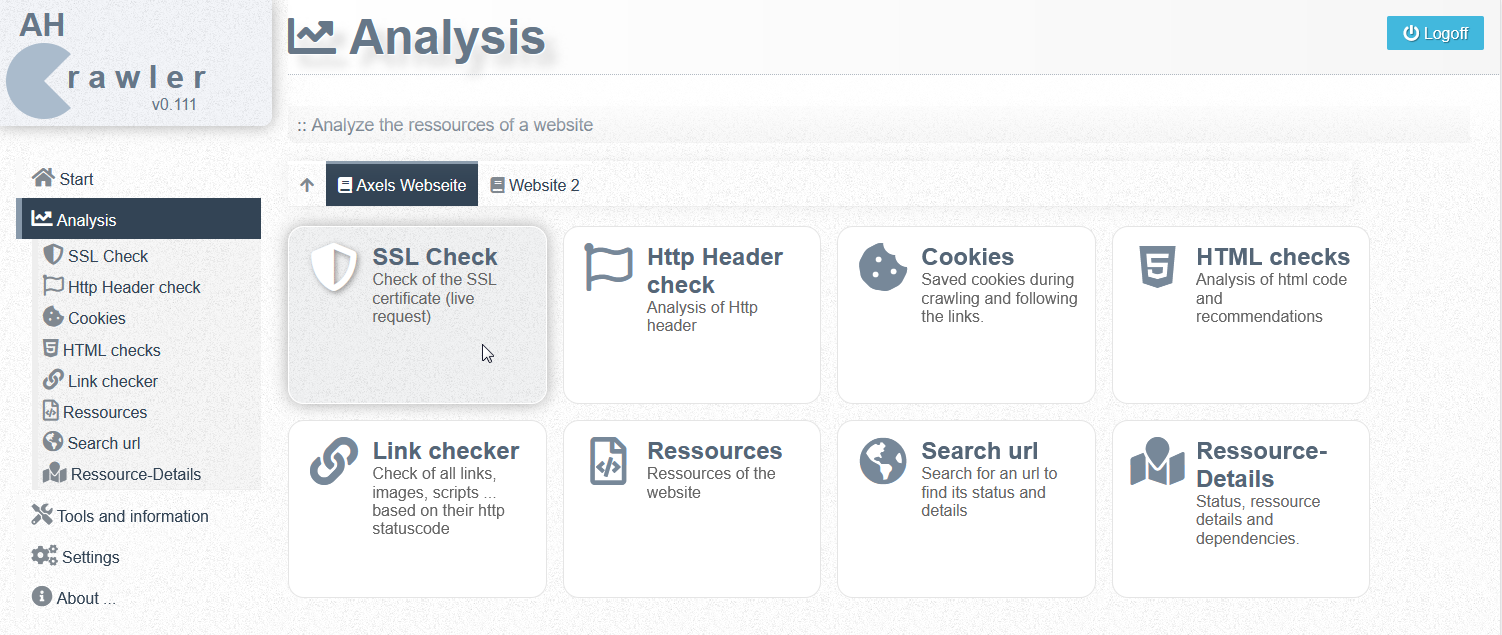

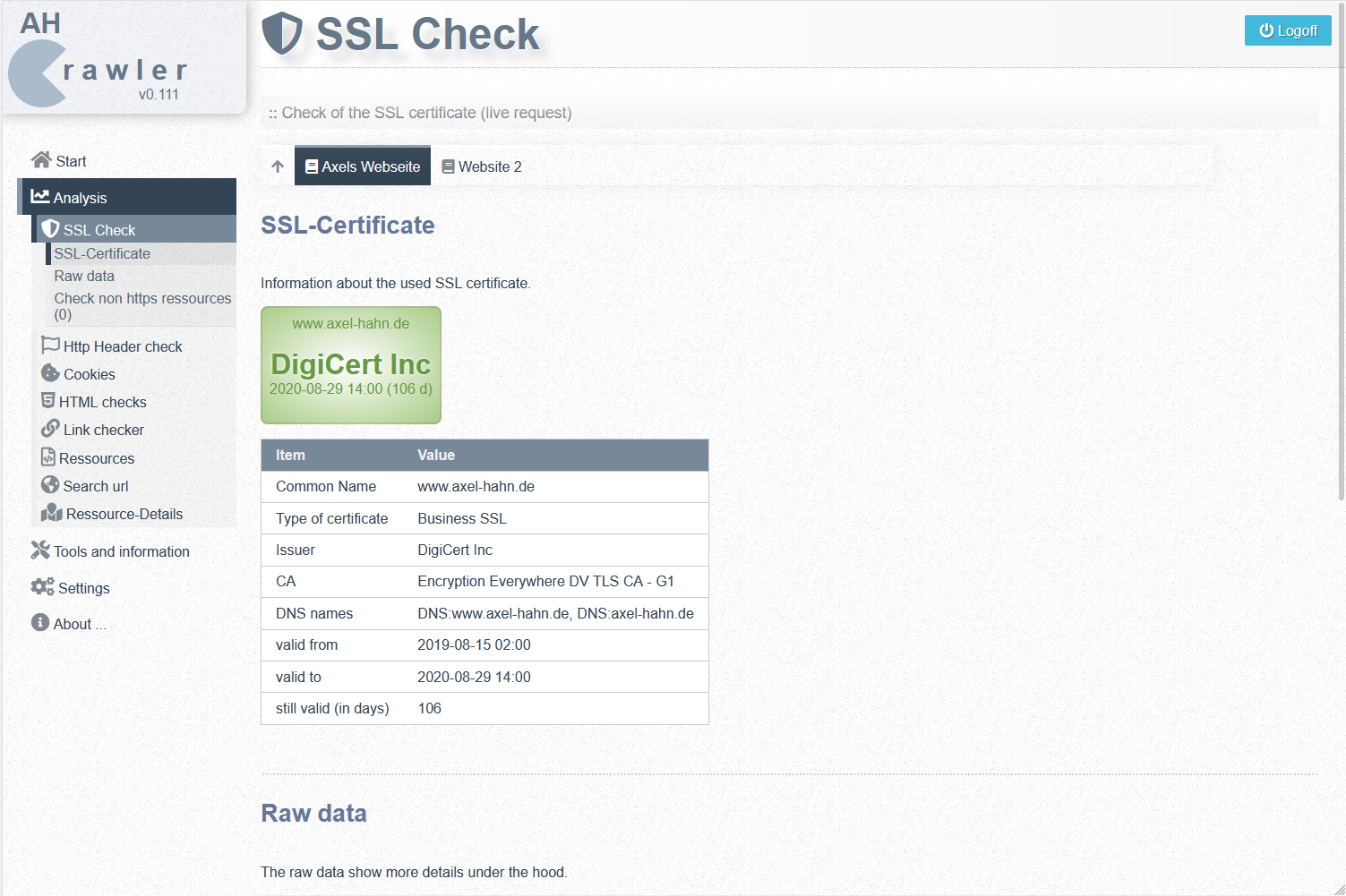

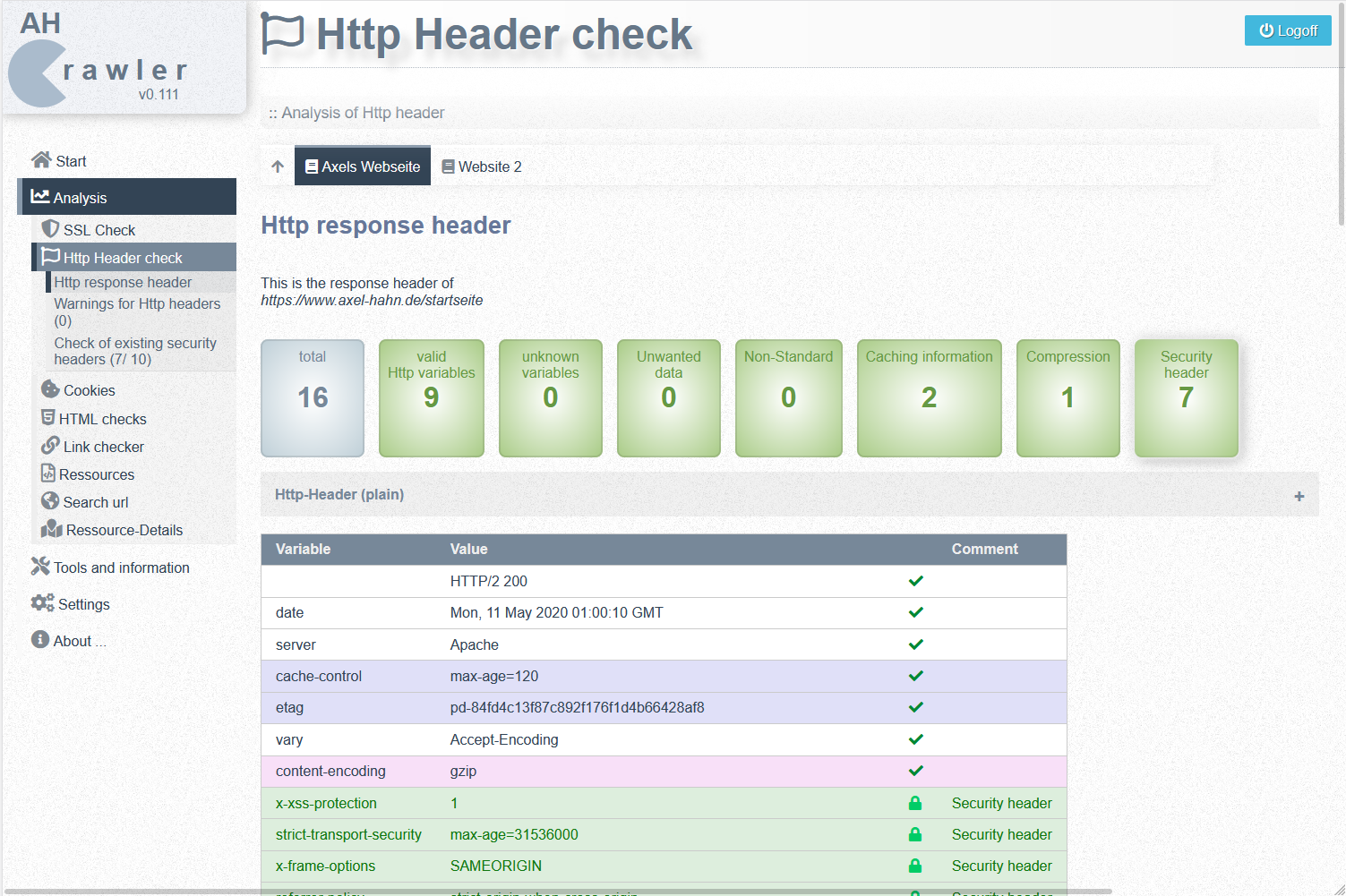

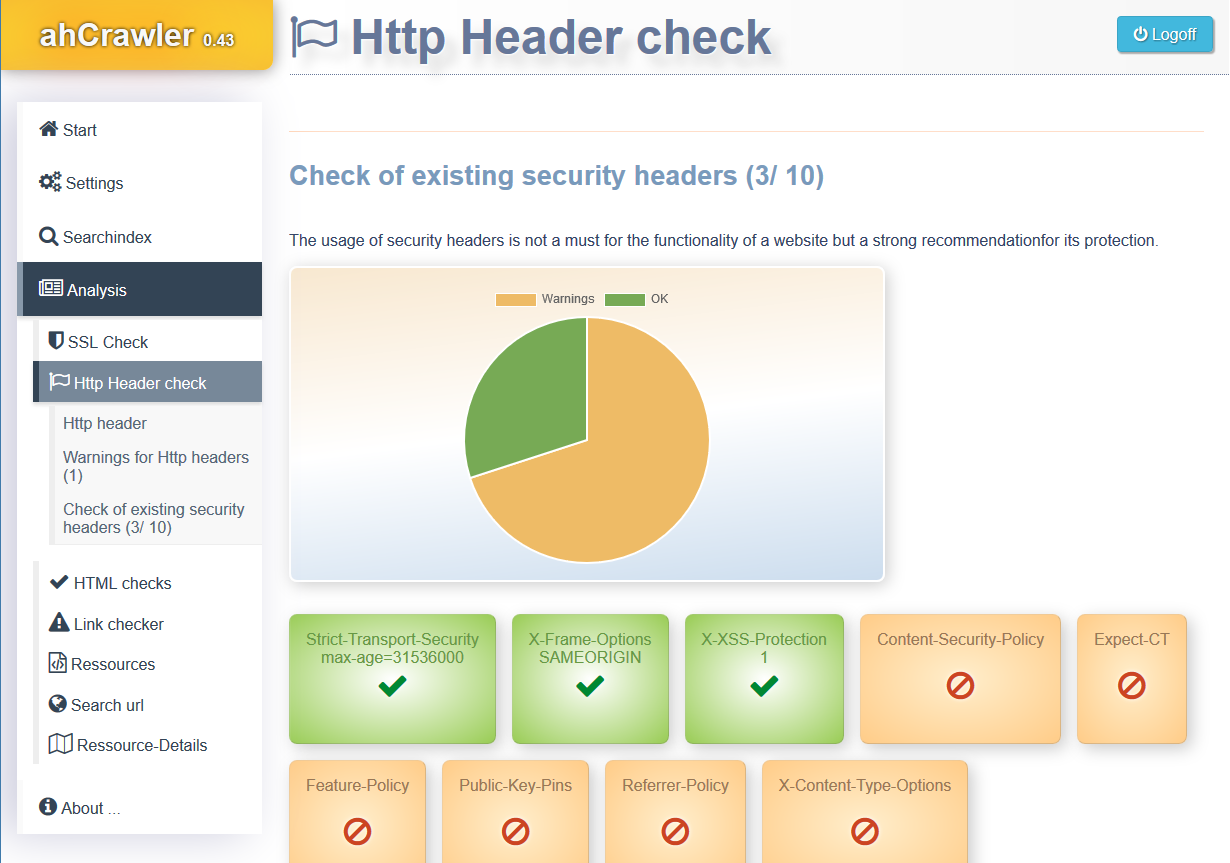

Ein Admin-Backend hat Zugriff auf den Suchindex, eingegebene Suchbegriffe und die Webseiten Analyse mit Linkchecker.

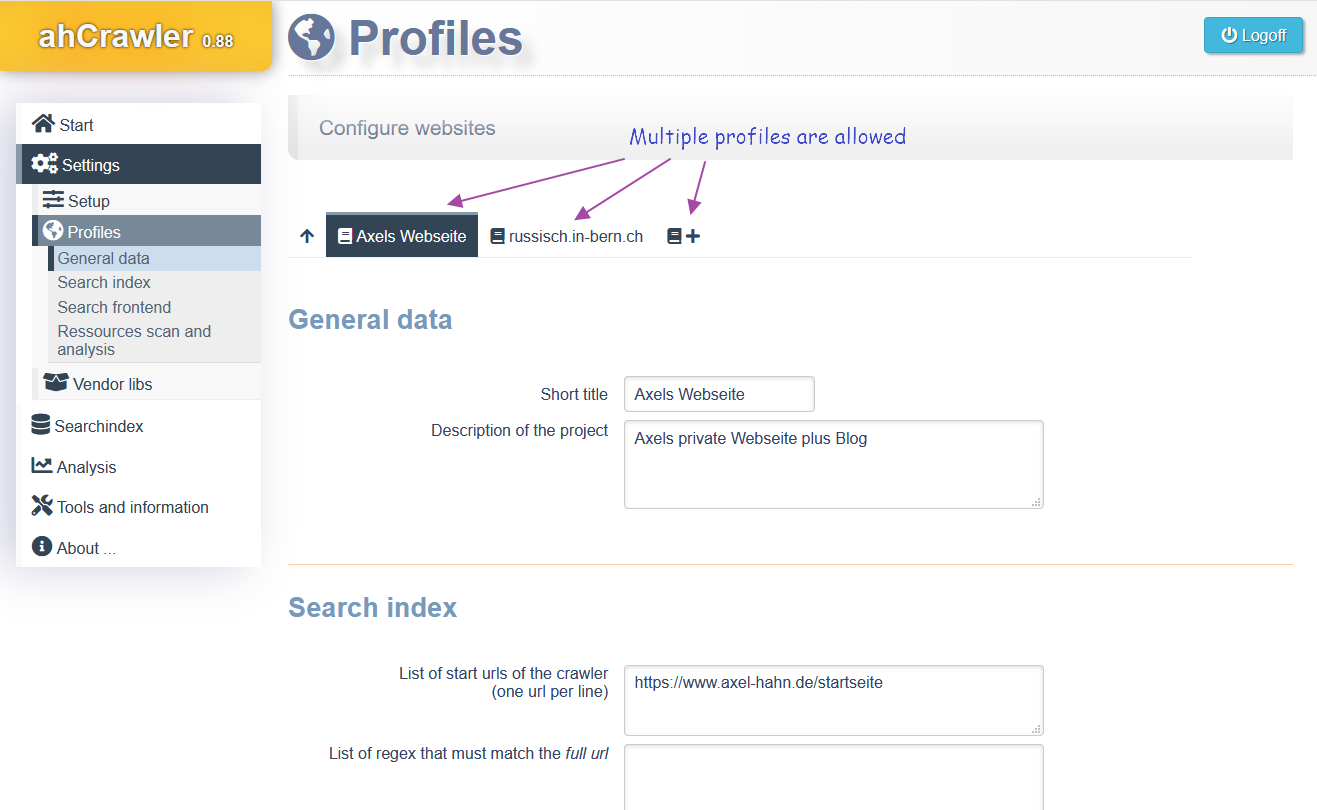

Es können mehrere Profile für mehrere Domains verwaltet werden.

Anforderungen:

- PHP 7

- php-pdo und Support für Sqlite oder Mysql/ MariaDB

- php-curl

- php-mbstring

- php-xml

Features:

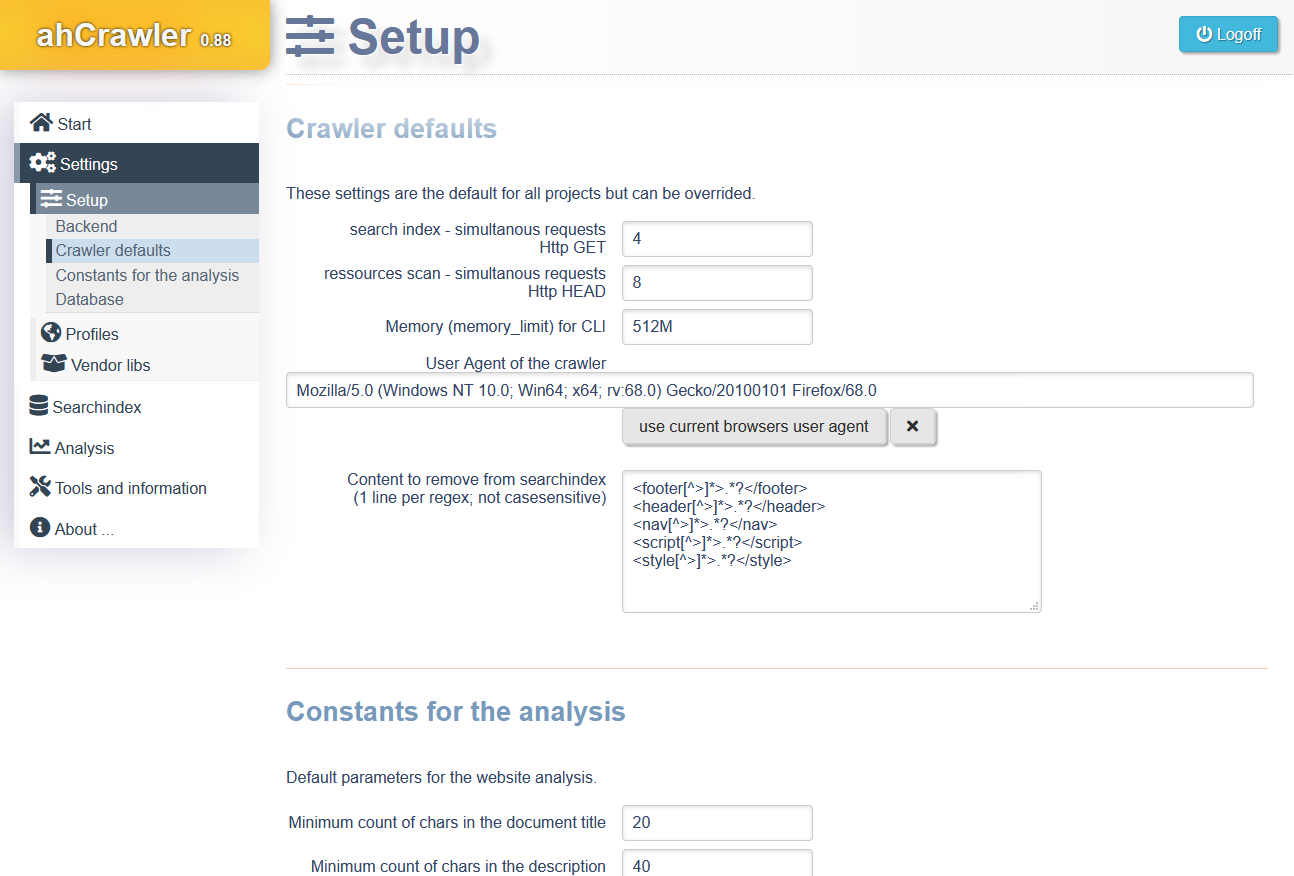

- Der Crawler wird per Kommandozeile gesteuert. Er berücksichtigt Ausschlussergeln der robots.txt, Meta-Anweisungen für no-index und no-follow, rel=nofollow in den Links als auch X-Robots.

- Mit Hilfe von Regex lassen sich zusätzliche include und Exclude Regeln setzen.

- Auf der Webseite befindet sich die Suche. Man kann mit UND Verknüpfung auch nach mehreren Begriffen suchen und die Suche auch auf Unterverzeichnisse einschränken.

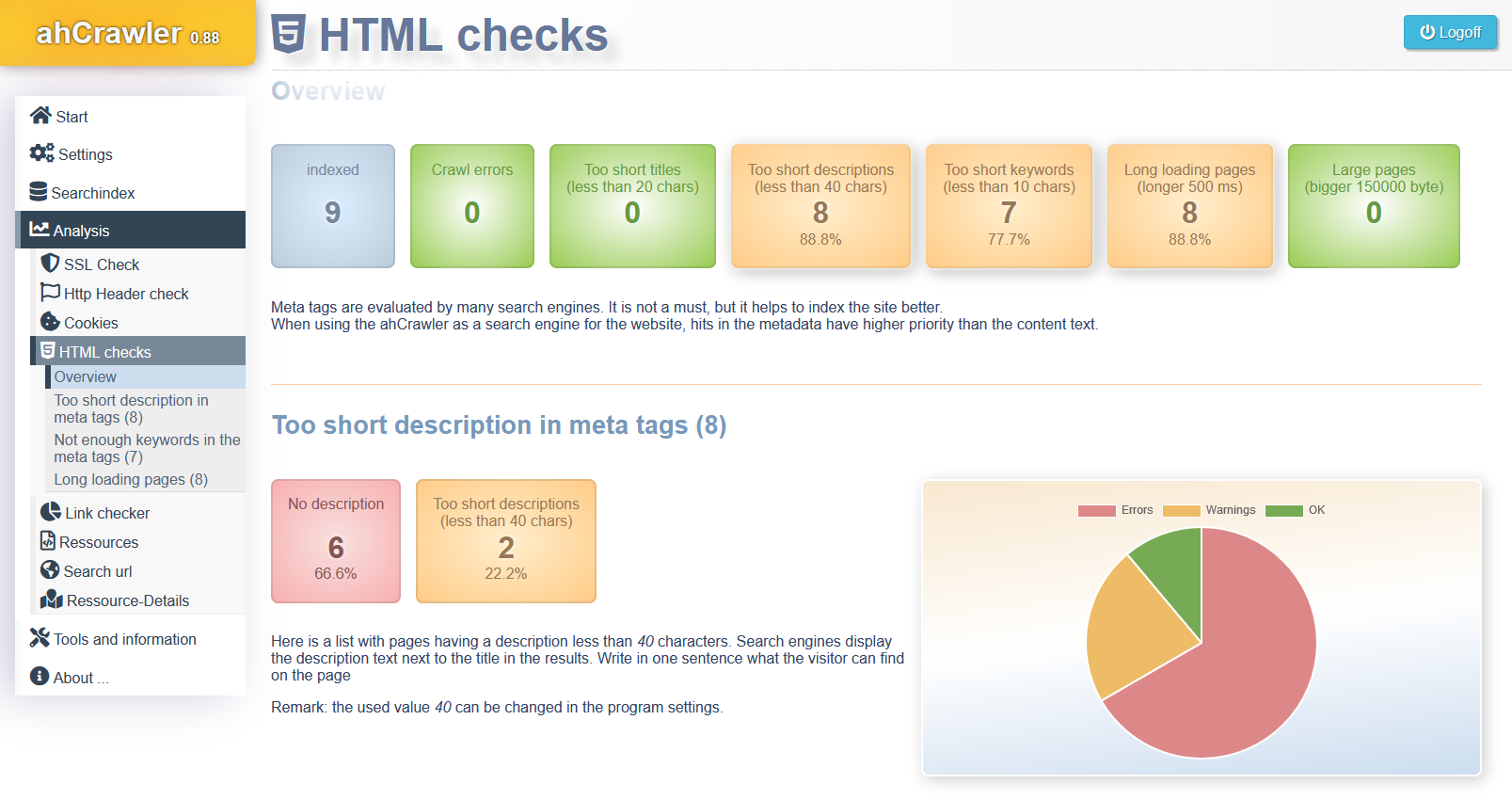

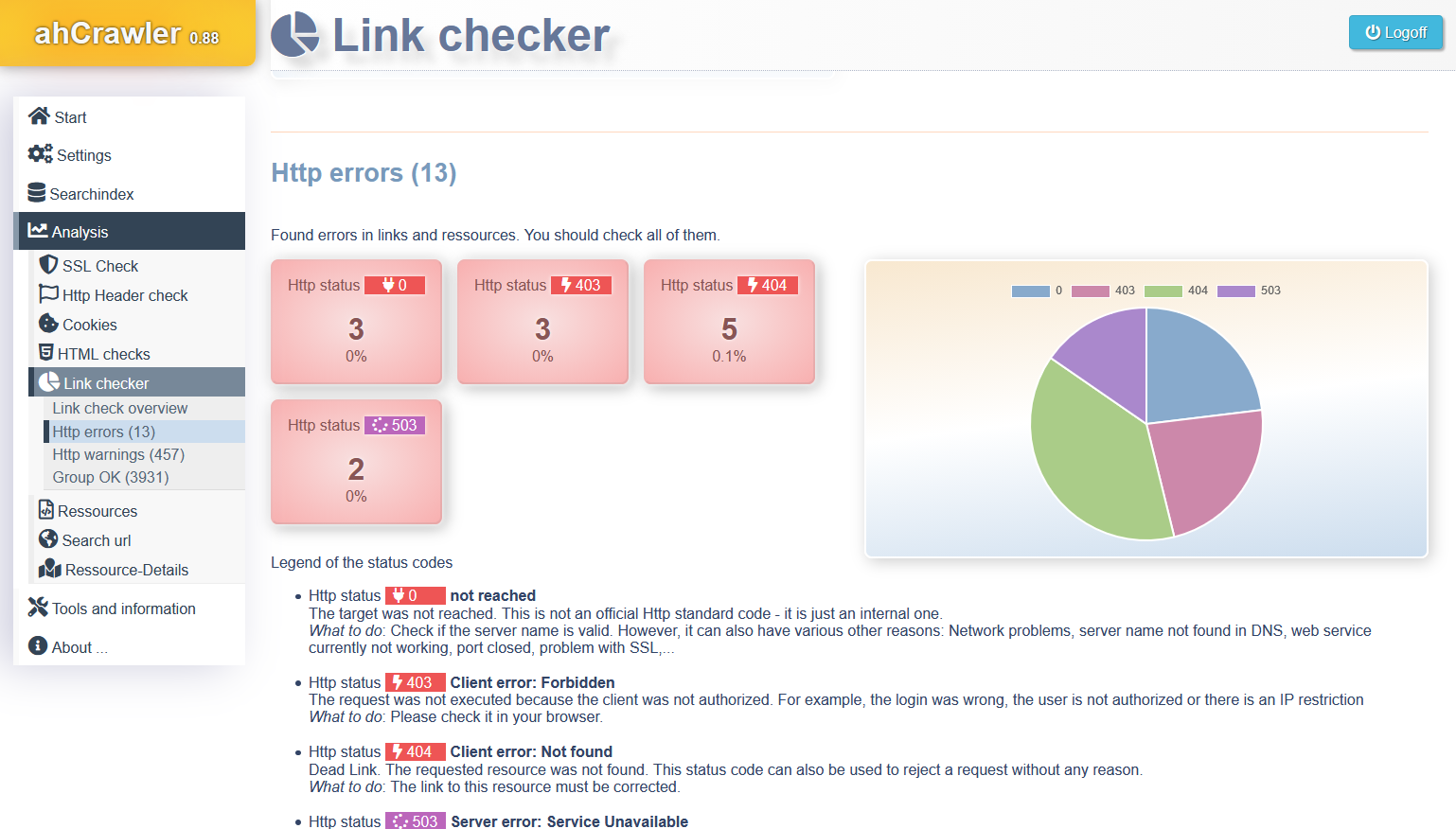

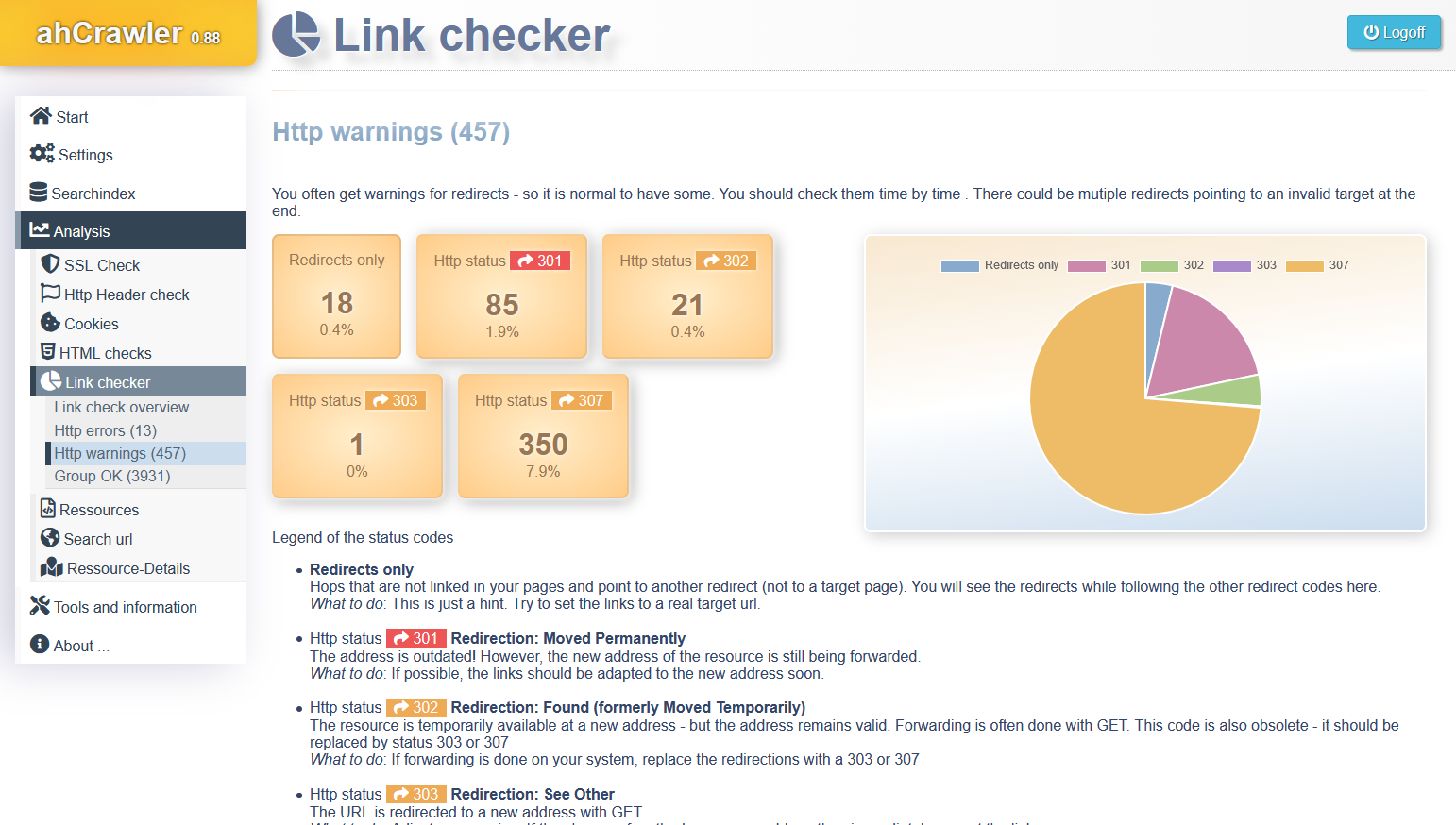

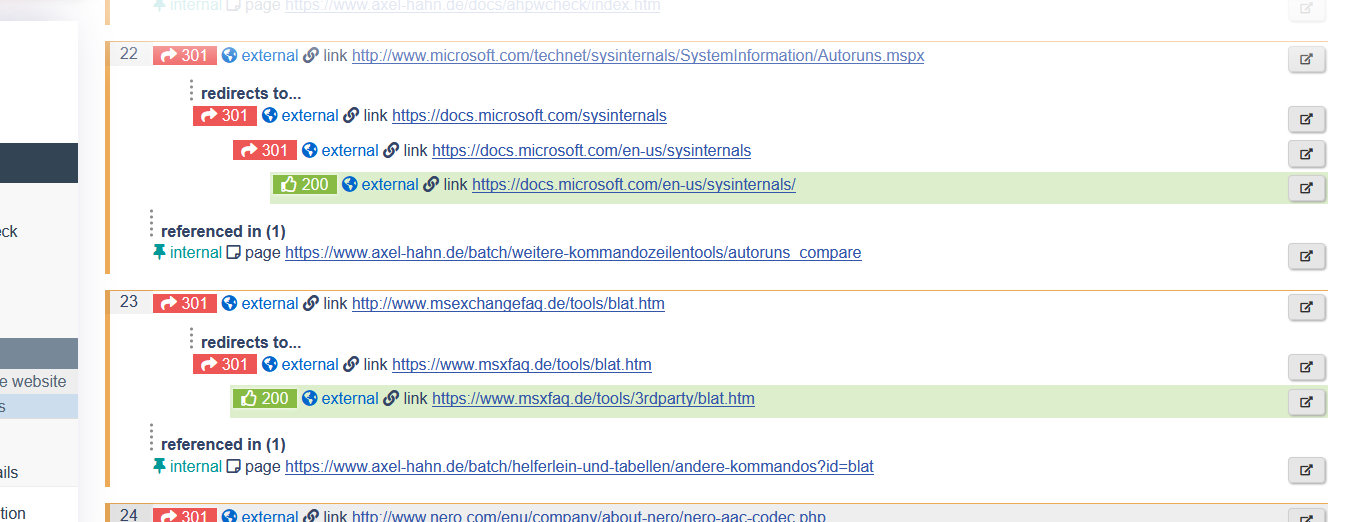

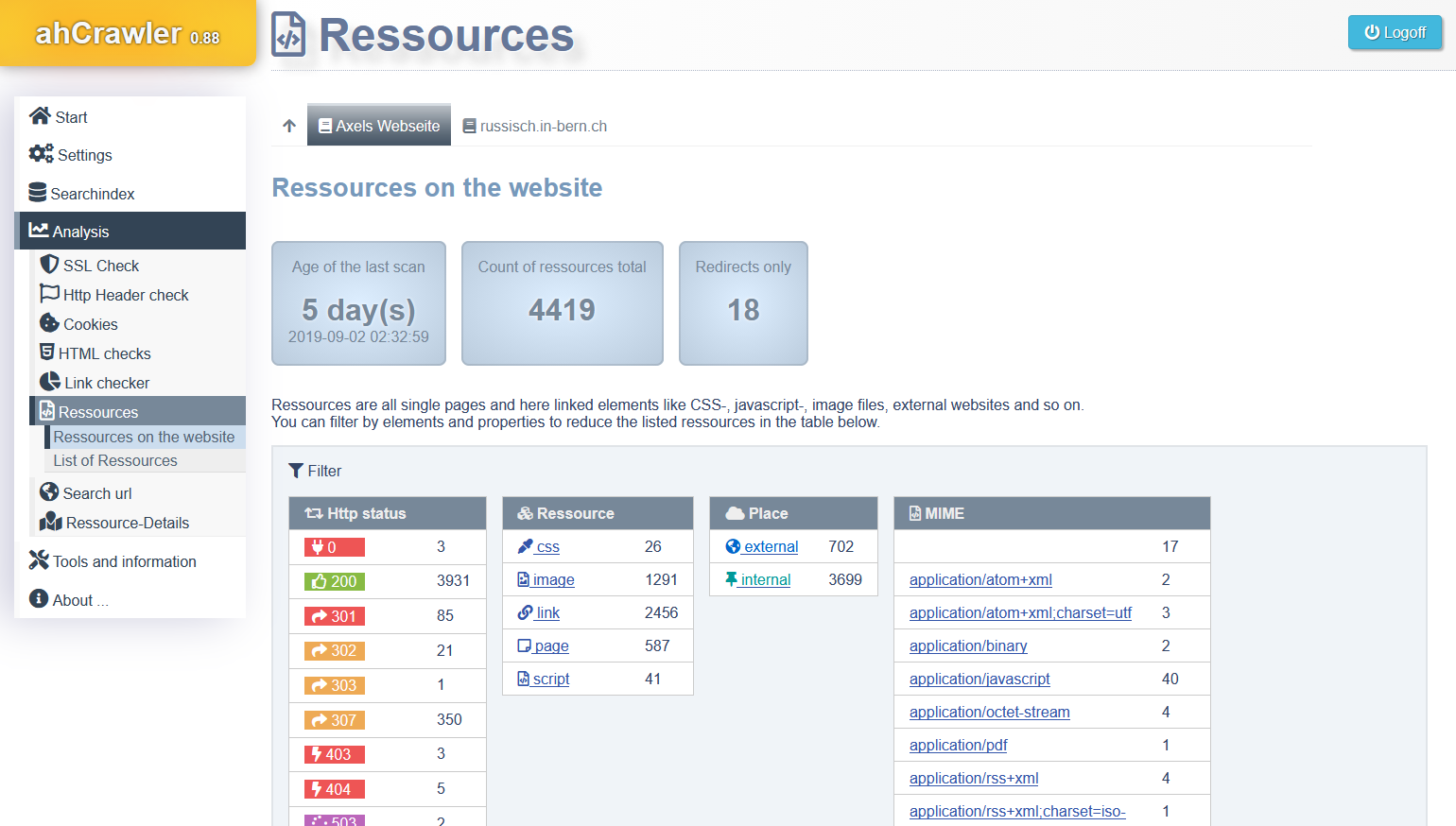

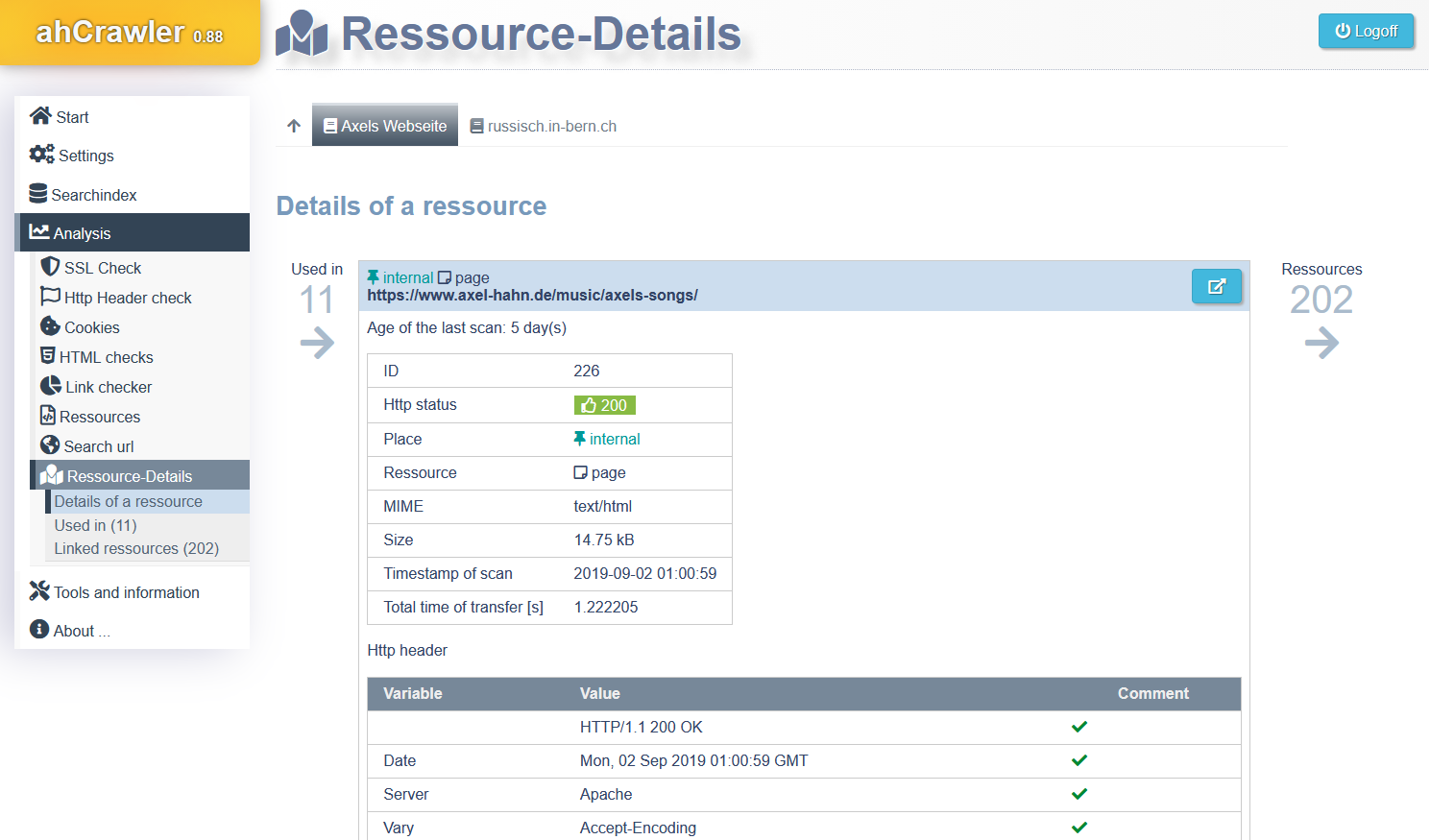

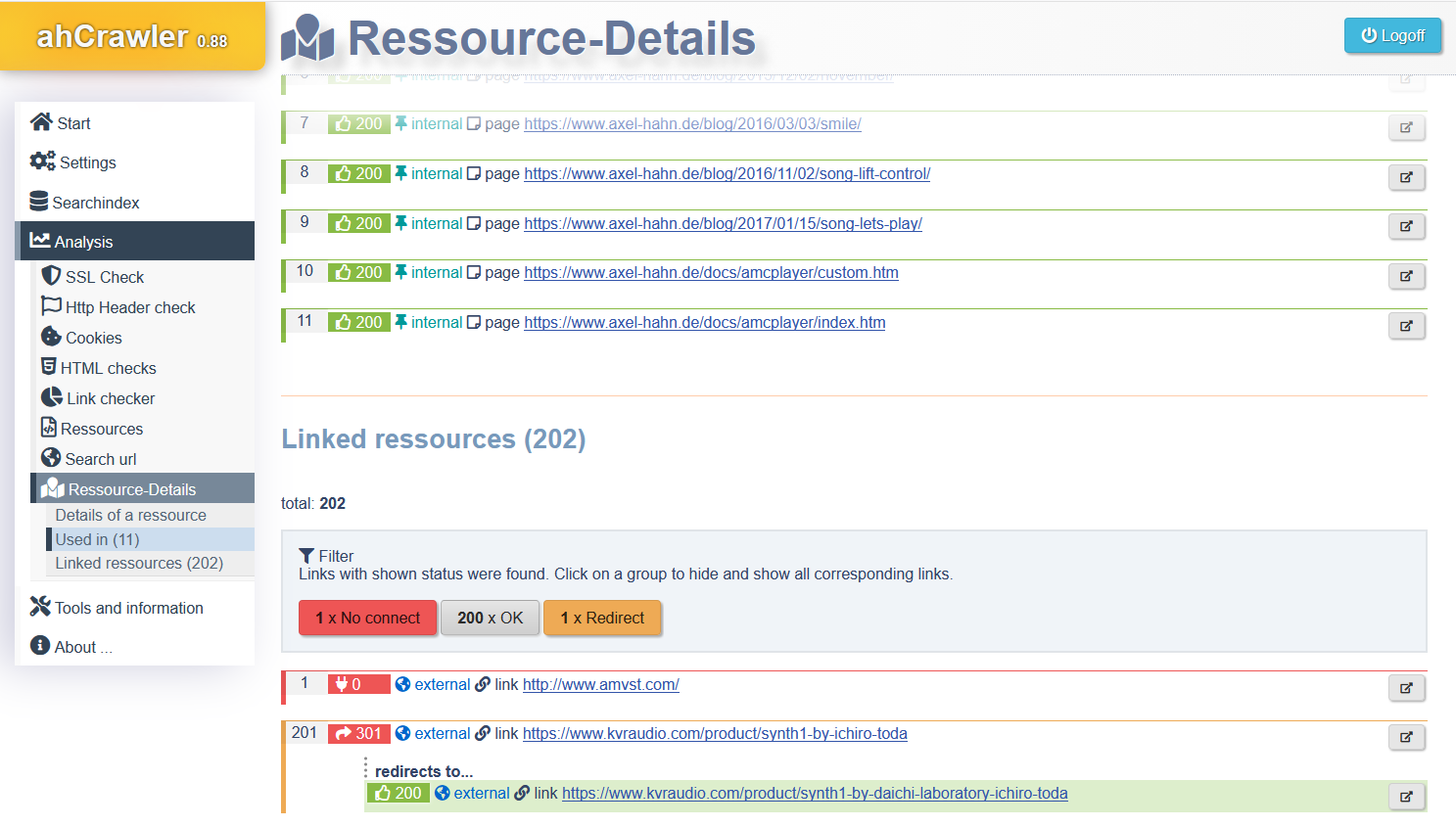

- Als Ressourcen werden von einer Webseite erfasst alle Links (A Href, Links im Html-Header, Frames + iFrames, Imagemaps), Bilder, CSS-Dateien, Javascripts. Für jede Ressource wird der Http-Status ermittelt wie auch die Abhängigkeiten (welche Seite verlinkt was) und in der Datenbank abgelegt. Im Backend lassen sich so Reports zu Fehlern und Hinweisen generieren.

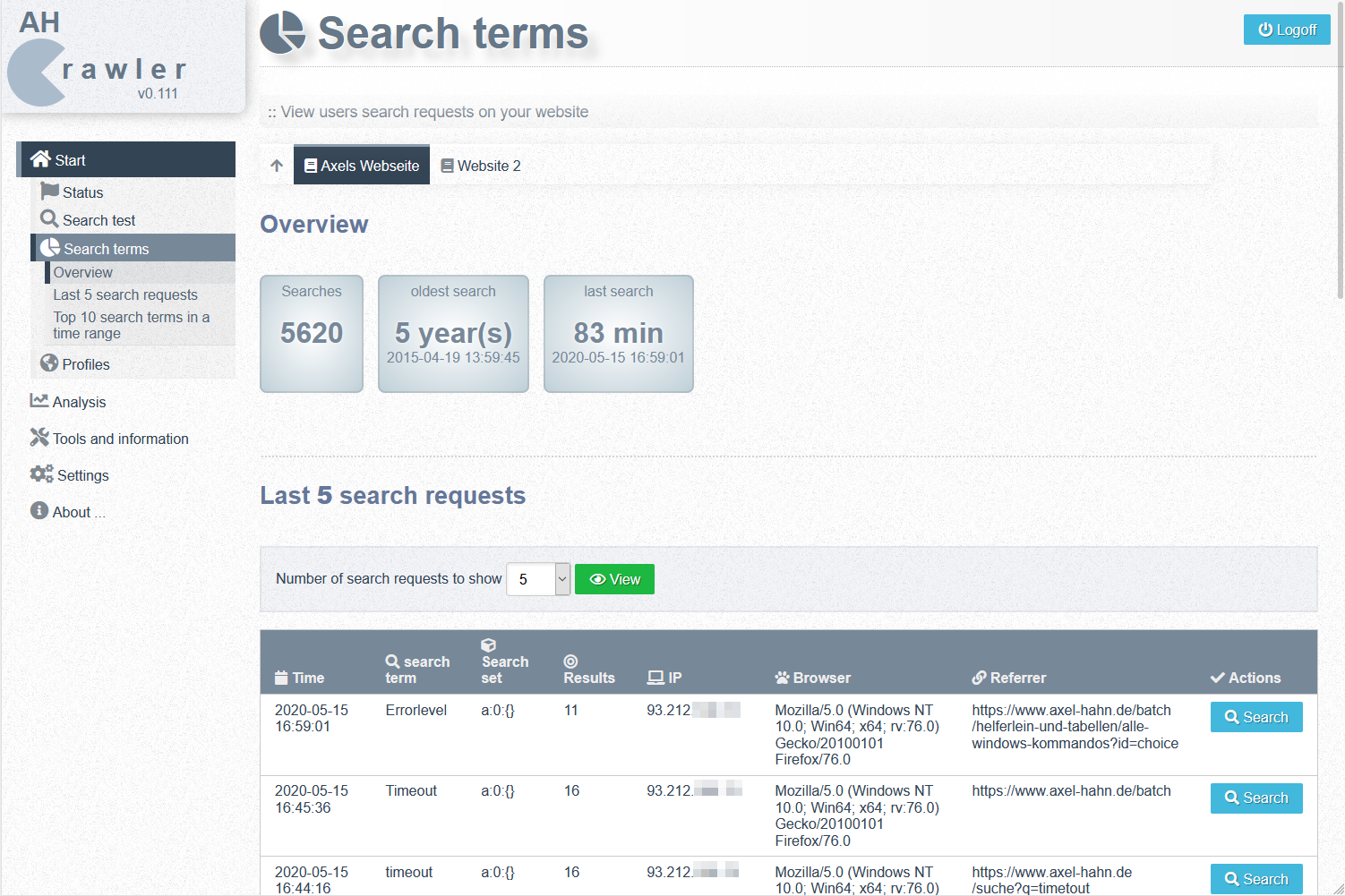

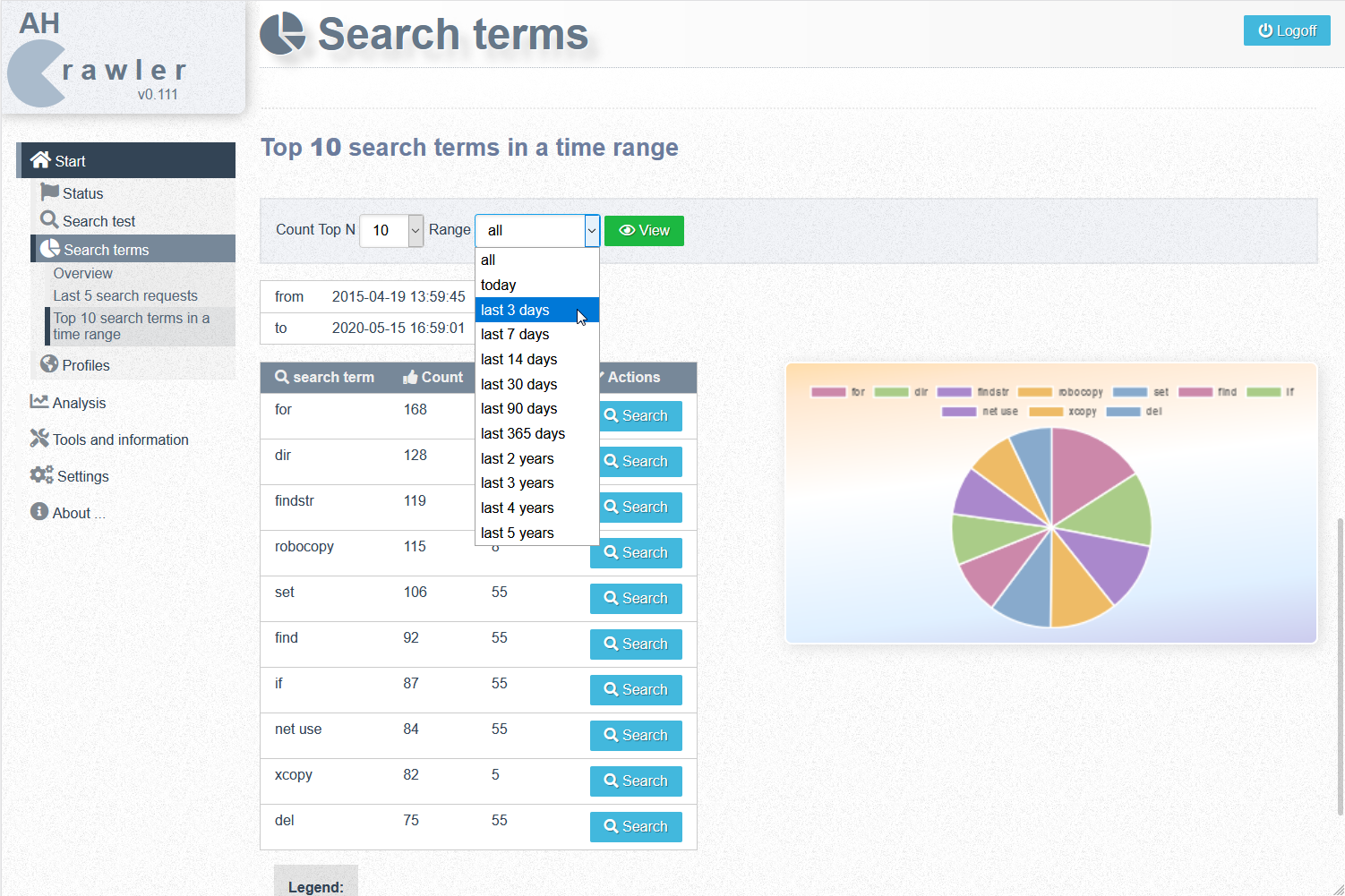

- Eingegebene Suchbegriffe werden aufgezeichnet und können statistisch ausgewertet werden.

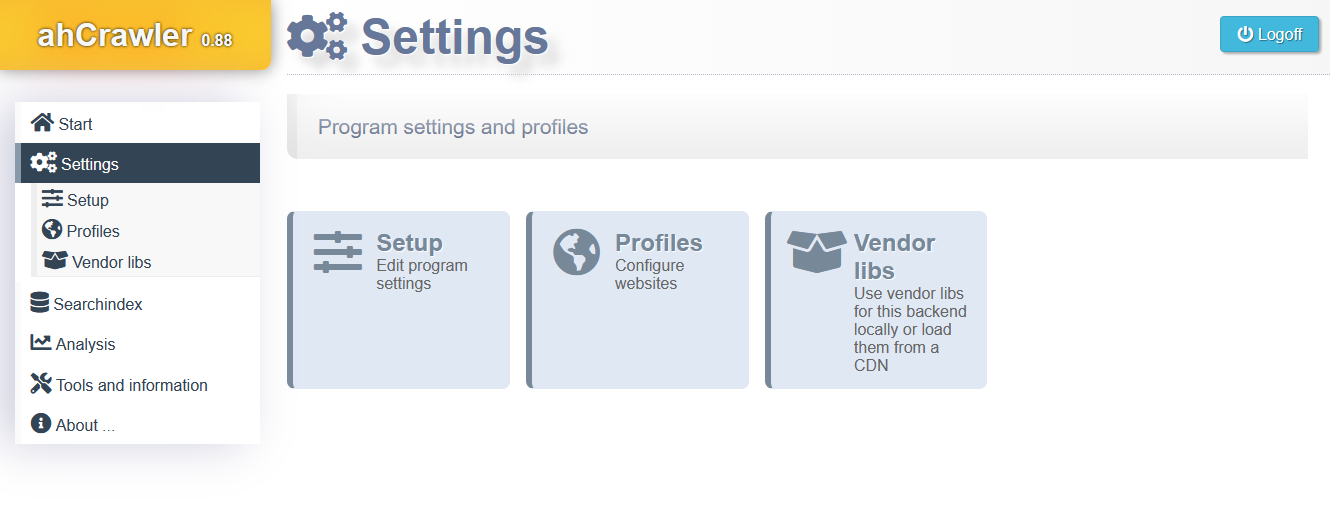

- Es gibt eine passwortgeschützte Weboberfläche. In dieser lassen sich für alle Profile einsehen: der Stand des Suchindex und die Suchbegriffe, Webseiten-Analyse mit fehlerhaften Links und Warnungen, Browsing und Filter durch alle Ressourcen

- In einer Installation werden mehrere Domains für Suche/ Analyse unterstützt.

Lizenz:

- GNU GPL v3 (Opensource)